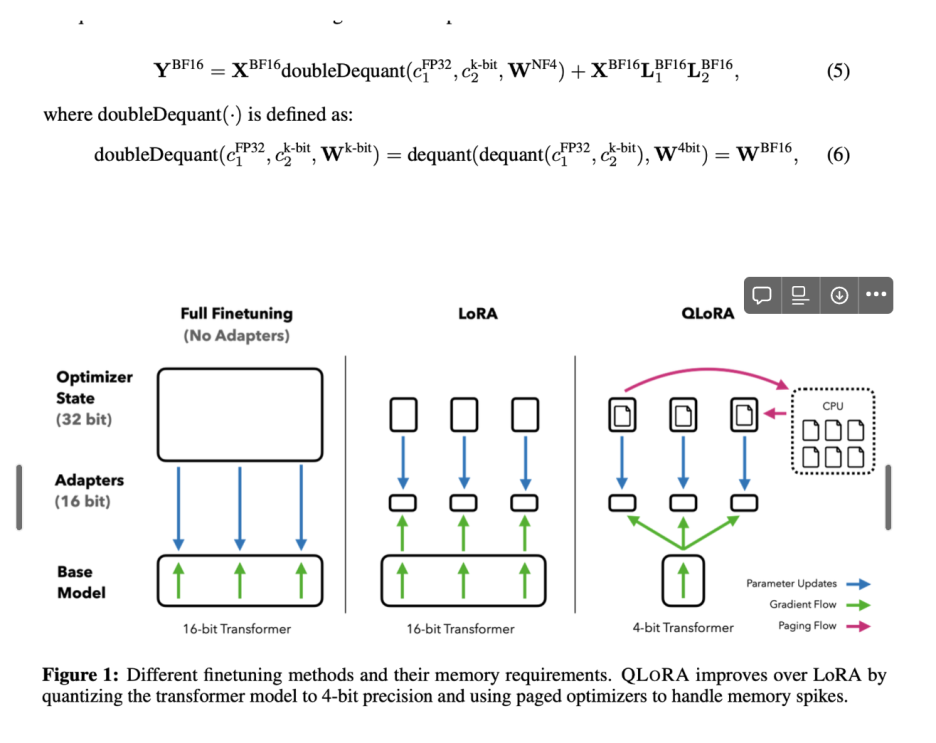

안녕하세요, 오늘은 QLoRA (Quantized Low-Rank Adapter) 에 대해 간단하게 리뷰해보도록 하겠습니다.QLoRA는 파라미터 효율적 미세 조정(PEFT, Parameter-Efficient Fine-Tuning)을 위한 방법 중 하나로, 대형 언어 모델(LLM)을 저비용으로, 더 적은 자원으로 미세 조정하기 위해 설계되었습니다. 특히 FP4(4-bit 부동소수점) 양자화와 낮은 Rank 어댑터(Low-Rank Adapter)를 결합하여 효율성과 성능을 극대화합니다. 그렇다면, LoRA와 QLoRA의 차이가 무엇일까요? LoRA는 기존 모델의 일부 파라미터만 저랭크 형태로 미세 조정하여 메모리와 연산 비용을 줄이는 방법이고,QLoRA는 LoRA에 4비트 양자화를 추가하여 더 적은 메모..