오늘은 MIT Gilbertstrang 교수님의 Linearalgebra 16강 Projection matrices and least squares를 배우겠습니다.

Projections(사영)

If b is perpendicular to the column space, then it’s in the left nullspace N(AT) of A and Pb = 0. If b is in the column space then b = Ax for some x, and Pb = b.

1. perpendicular한 경우 : b가 column space에 수직이라면 Pb = 0이다. (vectors in the left nullspace of AT)

2) column space 안에 있는 경우 : b가 column space에 있다면 Pb = b이다. (column space 안에 있다면 다 Ax이다.)

아래의 그림으로 보면 b가 column space에 perpendicular 한 경우에는 p로, left nullspace에 projection 하면 e이다.

I − P has all the properties of a projection matrix. I − P는 모든 projection matrix(사영행렬)의 형태를 가진다.

Least squares : minimize ||Ax − b||2 = ||e||2

We want to find the closest line b = C + Dt to the points (1,1), (2,2), and (3, 2). The process we’re going to use is called linear regression; this technique is most useful if none of the data points are outliers.

점 (1,1), (2,2), (3,2)에서 가장 가까운 선 b = C + Dt를 구하고자 한다. 선형 회귀(Linear regression)을 사용하는 방법은 데이터 점들 중 어느 하나라도 이상점(outliers)이 없는 경우에 가장 유용하다.

By “closest” line we mean one that minimizes the error represented by the distance from the points to the line. We measure that error by adding up the squares of these distances. In other words, we want to minimize ||Ax − b||2 = ||e||2.

"closest" 선은 점에서 선까지의 거리로 표시되는 오차를 최소화하는 선을 의미한다. 이 거리의 제곱을 합하여 오차를 측정한다. 즉, ||Ax − b||2 = ||e||2를 최소화하고자 한다.

There are two ways of viewing this. 두가지 방법이 있다.

방법1. Linear algebra ATAxˆ = ATb 로 normal equation을 구한다.

방법2. Calculus 미적분학을 사용하여 두 변수의 다음 함수의 최솟값을 구한다.

We could also have used calculus to find the minimum of the following function of two variables

그럼에도 불구하고, Least square는 제곱을 하기 때문에 outlier를 overcompensate하는 한계를 가지고 있다.

Matrix AT A

We’ve been assuming that the matrix AT A is invertible. Is this justified?

If A has independent columns, then AT A is invertible.

To prove this we assume that AT Ax = 0, then show that it must be true that x = 0:

행렬 AT A가 가역적이라고 가정해 왔는데, 이것이 정당한가?

A가 독립적인 열을 가지면 AT A는 가역적이다.

이를 증명하기 위해 AT Ax = 0,이라고 가정하고 x = 0이라는 것이 참이어야 함을 아래에 보여준다.

Since A has independent columns, Ax = 0 only when x = 0.

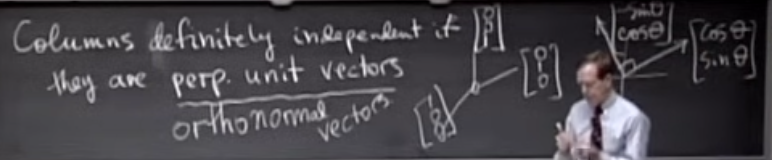

As long as the columns of A are independent, we can use linear regression to find approximate solutions to unsolvable systems of linear equations. The columns of A are guaranteed to be independent if they are orthonormal, i.e.

A는 독립적인 열을 가지므로 x = 0일 때만 Ax = 0이다.

A의 열이 독립적이라면 선형 회귀를 사용하여 해결할 수 없는 선형 방정식 체계에 대한 근사해를 찾을 수 있 있다.

A의 열이 orthonormal이면, 독립적임이 보장된다.

정리

1. Least squares : minimize ||Ax − b||2 = ||e||2

방법1. Linear algebra ATAxˆ = ATb 로 normal equation을 구한다.

방법2. Calculus 미적분학을 사용하여 두 변수의 다음 함수의 최솟값을 구한다.

풀이식 : AT Ax = AT b를 통해 p = Ax^

2.Matrix AT A : A가 독립적인 열을 가지면 AT A는 가역적이다.

'7. 수학공부 > 선형대수학' 카테고리의 다른 글

| Lecture18 Properties of Determinants (1) | 2024.12.26 |

|---|---|

| Lecture17 Orthogonal Matrices and Gram-Schmidt (0) | 2024.12.25 |

| Lecture15 Projections onto Subspaces (0) | 2024.12.19 |

| Lecture14 Orthogonal Vectors and Subspaces (0) | 2024.12.17 |

| Lecture12 Graphs, Networks, Incidence Matrices (0) | 2024.12.14 |